L’accélération de la création des données est souvent exprimée au travers de trois dimensions (les «

3V ») : le

volume, la

vélocité (fréquence et rapidité de transmission des données) et la variété des types de données. Ces données constituent une véritable mine d’informations pour améliorer la prise de décisions et automatiser des procédés industriels, par exemple.

D’où viennent toutes ces données ?

Aujourd’hui les données sont partout autour de nous mais sous différentes formes : sur des clés USB, sur les CD, DVD et autres Blu-ray ou dans les serveurs qui stockent les données présentes sur Internet. Nous créons chaque jour des quantités toujours plus importantes de données : géolocalisation, photos, vidéos, textes, sons... On estime qu’en 2020, 50 000 Gigaoctets de données seront échangées par seconde ! En 1992, ce volume était de 100 Gigaoctets par jour.

Dans le domaine scientifique, les données proviennent généralement de résultats de simulation ou d’expériences. Par exemple, une année complète d’expériences au

LHC (Large Hadron Collider) peut générer un milliard de Téraoctets.

Dans le domaine industriel, les entreprises peuvent mettre en place de nombreux capteurs pour connaître le comportement en temps réel de certaines machines ou dispositifs, ce qui améliore la maintenance (comme les moteurs d’avion dans l’aéronautique qui peuvent créer des données en continu sur leur consommation ou température).

Bref historique

du stockage des données

La quantité totale de données numériques a progressivement explosé avec l’augmentation de la capacité de stockage des supports informatiques. En 60 ans, le prix d’un Gigaoctet a été divisé par 520 millions. Le prix est passé de 26 millions d’euros à 0,05 € entre 1956 et 2016. L’usage des données a évolué avec le coût du stockage.

-

Au XVIIIe siècle, apparaissent les premières cartes perforées et l’ancêtre de l’informatique : la mécanographie. Ces cartes servaient à guider l’action de machines de façon « automatique ».

- Dans les années 1930, les

bandes magnétiques sont développées pour enregistrer du son et, plus tard, des images. Les données stockées étaient de l’ordre de 50 octets par cm de bobine.

-

En 1956, est créé le premier

disque dur d’une capacité de 5 Mo. Le prix du Mégaoctet (Mo) est alors de 10 000 dollars. C’est le premier stockage numérique de l’histoire.

-

En 1967, la première

disquette est mise au point avec un disque magnétique de 20 cm de diamètre. Malgré une capacité de 80 octets et un prix abordable, sa taille est un gros défaut. Progressivement la taille des disquettes diminue. En 1984, les disquettes de 8 cm se démocratisent. Plus portatives, elles ont une capacité qui varie entre 770 ko et 1,4 Mo.

- En

1982, les premiers

CD sont commercialisés : ils vont progressivement remplacer les vinyles, avec une capacité de stockage de 500 à 700 Mo. En 1995, les premiers

DVD apparaissent et remplacent peu à peu les VHS (cassettes vidéo avec bande magnétique) avec une capacité de 5 Go. En 2006, les premiers

Blu-ray sont lancés : ils ont une capacité pouvant atteindre les 50 Go.

- Dans les

années 2000, les

clés USB se répandent avec une capacité de 8, 16 et 32 Mo au début. Leur atout majeur : leur taille et leur résistance aux chocs.

-

En 2007, les premières offres de stockage par «

Cloud » sont proposées.

Comment traiter autant d’informations ?

Pour traiter la quantité croissante et phénoménale de données on distingue deux types de moyens (matériel et logiciel) qu’il faut combiner :

-

Les supercalculateurs (matériel). Les calculateurs sont des moyens de traitement qui vont jusqu’aux supercalculateurs. Ils sont constitués d’un grand nombre de processeurs qui peuvent être répartis en réseau parfois distants, ou regroupés en ‘clusters’ ; dans ce dernier cas, on peut créer des supercalculateurs de très grande puissance pouvant résoudre de manière concentrée des grands problèmes qu’il est difficile ou impossible de répartir sur des moyens distribués. La proximité rend possible des communications ultra-rapides pour réaliser rapidement et simultanément un très grand nombre d’opérations de calcul ou de traitement de données.

Pour en savoir plus sur les supercalculateurs.

-

Les algorithmes (logiciel). Un supercalculateur a besoin d’être « guidé » par un programme informatique pour effectuer les tâches qu’on attend de lui : c’est le travail des algorithmes. L’avancée des recherches sur les algorithmes a ainsi permis de faire émerger ce qu’on appelle l’apprentissage automatique ou machine learning en anglais, qui désigne la capacité d’une machine (au sens large) à repérer des tendances ou des corrélations dans un très grand volume de données, en adaptant ses analyses et ses comportements. C’est notamment utilisé pour détecter des régularités dans le comportement des consommateurs, des indices économiques ou encore du trafic routier… Mais attention, les règles prédictives qui en sont tirées ne sont que l’image de ce qui a déjà eu lieu ; ce ne sont pas des lois générales.

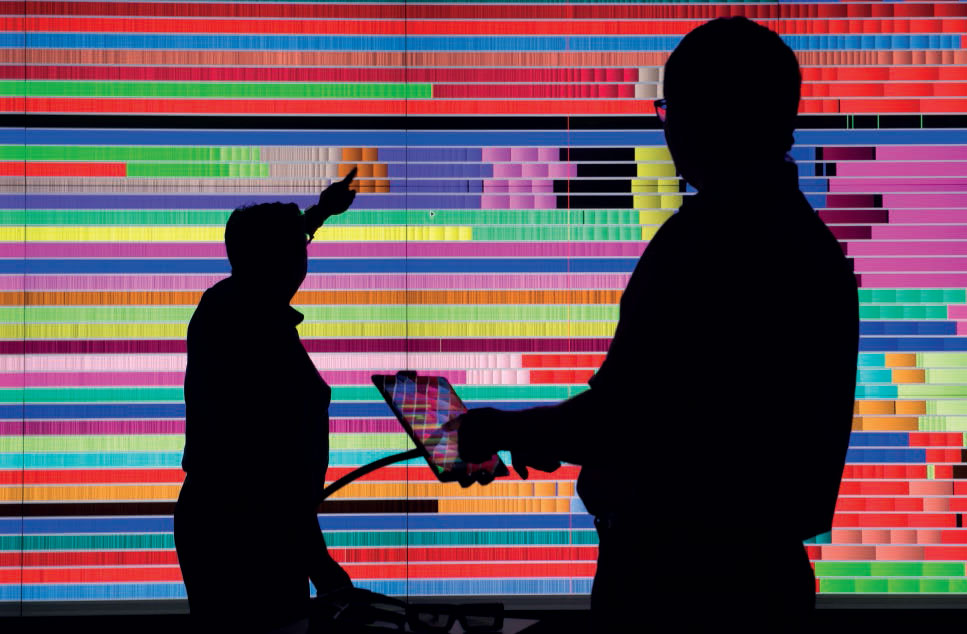

Analyse et visualisation des traces d’exécution pour comprendre et améliorer les performances d’une application. © Inria

Quel est l’intérêt de toutes ces données et de leur traitement ?

Les données sont une matière première essentielle pour la science, notamment, pour faire progresser la connaissance mais aussi pour les entreprises qui veulent éviter les prises de décisions risquées.

En physique, le traitement de plusieurs milliards de Gigaoctets de données au LHC a permis l’une des plus grandes découvertes de la physique :

le boson de Higgs.

Autre exemple : les données récoltées autour du monde à l’aide de satellites permettraient la conception de modèles météorologiques pour mieux anticiper les événements extrêmes comme les cyclones.

Grâce aux progrès des supercalculateurs, la simulation numérique (calculs permettant de représenter un phénomène physique ou complexe sur un ordinateur) s’est généralisée à toutes les disciplines au point de devenir le « troisième pilier » de la méthode scientifique, aux côtés de la théorie et de l’expérimentation.

Depuis quelques années, le calcul intensif, producteur de masses de données de plus en plus importantes, devient également un maillon indispensable du traitement des « mégadonnées » d’autres origines (expériences, observations, réseaux de capteurs, Internet…). Les techniques et méthodes du

calcul haute performance (HPC) se retrouvent ainsi au cœur de processus mêlant production et analyse de données, modélisation numérique, techniques statistiques et d’apprentissage, intelligence artificielle...

Tout comme pour les scientifiques, les entreprises vont rechercher des applications prédictives. Savoir ce que peut rechercher un utilisateur en fonction de ses informations personnelles et actions précédentes sur Internet (navigation) par exemple. L’utilisation du Big Data peut également permettre aux entreprises de trouver de nouvelles offres et d’innover. Enfin

l’usine du futur, dotée de capteurs, pourra traiter et analyser de nombreuses données en temps réel : replanification en temps réel de la production en cas d’incidents, contrôle de la qualité et des performances des différents équipements, gestion de l’énergie…

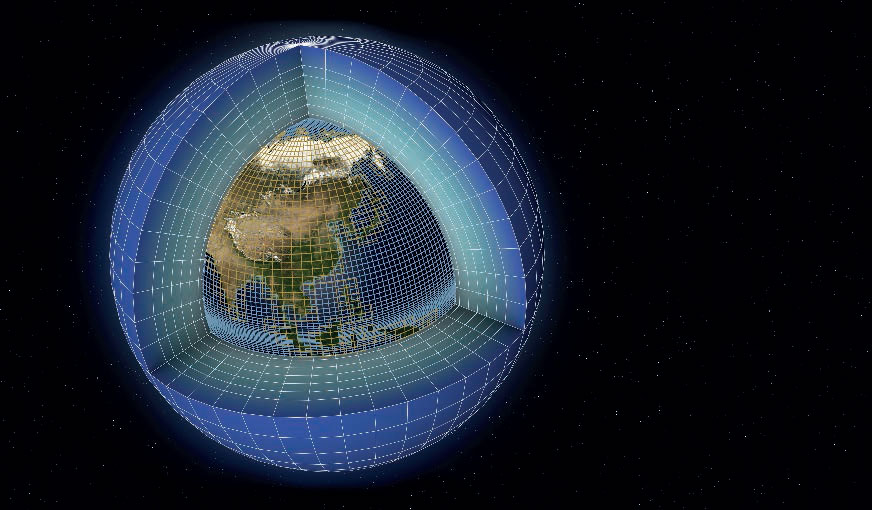

Les modèles numériques de climat sont construits autour de deux « coeurs dynamiques », l’un pour l’océan et l’autre pour l’atmosphère, résolvant les équations de la mécanique des fluides sur une sphère tournante. C’est le modèle dit « système Terre ». La figure montre les maillages des deux coeurs dynamiques. Le maillage sur les continents est celui de l’atmosphère. Chaque milieu utilise comme conditions limites les informations fournies par l’autre modèle, avec une fréquence d’échange allant de l’heure à la journée. © IPSL

Quelles sont les limites du Big Data ?

Une première limite est celle de la pertinence et de la véracité des informations. Si des biais ou des erreurs existent dans les données utilisées, leur traitement automatique les reproduira, ce qui faussera les interprétations et les analyses qui en seront tirées. En astrophysique par exemple, l’estimation de certaines valeurs étant difficile avec les technologies actuelles, des approximations sont introduites dans les équations pour accélérer le temps de calcul ou obtenir une solution analytique. Dans l’industrie aussi, les erreurs de données peuvent entrainer de nombreuses difficultés. Si un capteur est mal réglé ou entretenu par exemple, les résultats obtenus seront faux et les prédictions qui pouvaient être faites seront erronées. Il est donc nécessaire de bien maîtriser ces « erreurs » d’approximation.

Une deuxième limite est celle de la surinterprétation de causalités. Ce n’est pas parce qu’un algorithme repère des corrélations entre différentes données qu’il s’agit de relations de causalité : même si les statistiques montrent qu’on a plus de probabilités de mourir dans un lit d’hôpital que dans son propre lit, il ne faut pas en déduire que les hôpitaux sont les endroits les plus dangereux.

Une troisième limite est celle de la reproductibilité des résultats scientifiques. En astrophysique par exemple, avec d’énormes volumes de données et des algorithmes très complexes, il est souvent impossible pour un chercheur de reproduire les figures d’un article. Or la reproductibilité est au cœur de la démarche scientifique. De plus en plus, aujourd’hui, les scientifiques publient avec leurs résultats les codes sources ayant servi à analyser les données et les scripts utilisés pour les traiter et générer les figures. La mise à disposition des données a de nos jours tendance à s’intensifier aussi au travers de «

l’open data ».

Enfin, l’utilisation intensive de données ne peut pas totalement remplacer l’approche théorique. Aurait-on pu découvrir les concepts fondamentaux de la physique simplement à partir des données ? La question reste posée aujourd’hui encore même si, en son temps, Albert Einstein avait répondu par la négative.

Quels enjeux pour le Big Data ?

La collecte et/ou le traitement d’une quantité importante de données soulève des problématiques importantes pour les scientifiques et plus globalement pour la société à propos de :

-

la protection des données et des droits qui leur sont associés. C’est le principal enjeu du Big Data. Les scientifiques doivent protéger leurs résultats de recherches et les citoyens ont le droit à la protection de leurs données personnelles. Le développement des objets connectés (Internet des objets ou IoT) qui vont transmettre une quantité de plus en plus importante de données accentue cette problématique. Pour cela, des cadres juridiques sont progressivement renforcés.

-

l’encadrement et la gestion du « machine learning » pour éviter toute dérive. Pour cela, la mise au point d’un journal détaillant les étapes de l’apprentissage informatique est une piste de réflexion qui permettrait de faciliter les recours juridiques.

-

l’impact écologique du Big Data est un dernier enjeu puisque le fonctionnement des serveurs, supercalculateurs et moyens de stockages et de communication (réseaux avec ou sans fil) nécessitent une quantité importante d’électricité.

La gestion et l’utilisation efficace du Big Data reste tout de même un moyen d’accélérer l’acquisition de connaissances et donc de faire avancer les recherches scientifiques. C’est également un moteur de croissance important pour l’économie car il intéresse les PME, grands groupes ou administrations publiques. L’Internet des objets et les données massives générées offrent d’innombrables possibilités pour améliorer la qualité de vie et la sécurité des citoyens.